Receba nossas newsletters

É de graça. Só tem coisa fina, você vai curtir!

Até pouco tempo atrás, justiça racial aparentemente não fazia parte da lista de preocupações do maior conglomerado de redes sociais do mundo.

Foi somente após a repercussão do assassinato de George Floyd por um policial nos Estados Unidos, em maio de 2020, e do consequente fortalecimento do movimento #BlackLivesMatter, que funcionários do Facebook internamente engrossaram o coro sobre as falhas da empresa em apoiar pessoas negras e traçar políticas mais efetivas para avançar a agenda de justiça racial.

A discussão sobre raça se desenrolou nos meses seguintes às manifestações que eclodiram ao redor dos EUA e mudou a forma como a empresa hoje analisa dados demográficos, inclusive sobre raça, mostram diversos documentos do Facebook Papers vistos pelo Núcleo em parceria com a Folha de S.Paulo.

Até então, funcionários de diversos times esbarravam em um obstáculo importante: a falta de informações raciais de seus usuários -- justificada pela plataforma como uma questão de privacidade -- impedia o embasamento de políticas dessa pauta.

É importante porque…

- Ao longo dos anos, Facebook foi criticado por promover discriminação algoritmica em seus produtos, o que teve efeitos nocivos para minorias na plataforma

- Demonstra que, impulsionada por eventos externos, a empresa pode acelerar processos para gerar melhorias e consertar problemas

O site The Intercept Brasil abordou a questão racial em reportagem publicada em 1.dez – quando Núcleo e Folha já trabalhavam na apuração.

Quando as discussões sobre justiça racial ganharam força entre funcionários, o desafio foi efetivamente medir se usuários negros estavam sendo desproporcionalmente afetados ou desprivilegiados pelo algoritmo -- como o próprio Facebook ouviu em pesquisas que realizou.

Além do desafio, a ausência dessas informações também representava uma desvantagem frente a clientes e parceiros.

Mesmo sem acesso interno a dados sobre raça, outras empresas que trabalham com dados do Facebook, como por exemplo anunciantes, encontraram uma forma de driblar a ausência desse recurso: usando indicadores secundários como proxies para micro-direcionar anúncios para usuários negros, como mostrou reportagem do The Markup.

Na prática, esse “drible” faz com que, embora o anunciante não possa selecionar diretamente categorias raciais para o público-alvo, ele pode marcar categorias secundárias que o levam a esse público.

Ou seja, soluções para encontrar dados dessa importância existem há tempos.

“Uma visão mais cínica é que parte do motivo pelo qual evitamos medir a raça é porque não queremos saber o que nossa plataforma está realmente fazendo - particularmente no Facebook, se você não pode medir, não pode agir”, escreveu um funcionário em uma publicação.

No mesmo post, outros funcionários comentam que as equipes de Responsible AI e AI Policy estavam ativamente trabalhando com o tema para mapear caminhos possíveis de serem seguidos.

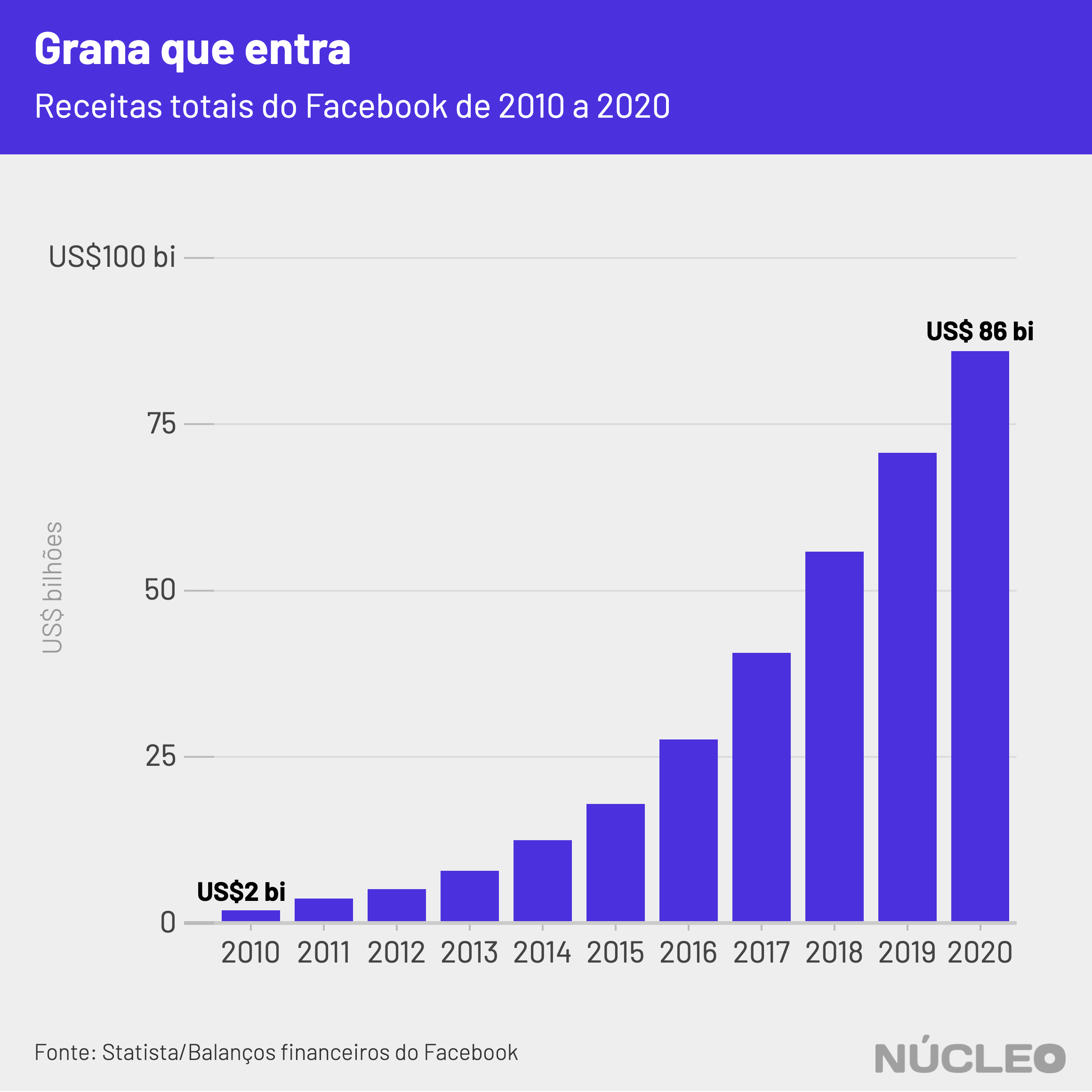

Recursos não faltam. O Facebook (que agora se chama Meta) é dono dos principais aplicativos de redes sociais do mundo, incluindo Instagram e WhatsApp, utilizados por bilhões de usuários.

A empresa registrou em 2020 receita total de US$86 bilhões, crescimento de 22% sobre o ano anterior, enquanto o lucro líquido disparou quase 60%, chegando a US$29 bilhões.

Em nota por email, a Meta disse o seguinte:

“Nossas equipes trabalham todos os dias para melhorar as experiências das comunidades marginalizadas que usam o Instagram e o Facebook. Esse trabalho está em constante evolução com base nas questões que encontramos em nossas plataformas e no feedback que recebemos da comunidade. Em novembro, nosso time de Direitos Civis divulgou um relatório de progresso, detalhando alguns dos avanços da empresa em relação à Auditoria de Direitos Civis realizada no ano passado. Por exemplo, o relatório destaca o nosso trabalho para desenvolver um processo de revisão para as equipes de produto, no qual avaliamos as possíveis implicações de direitos civis em novos produtos. Uma parte essencial desse esforço é nosso trabalho em conjunto com especialistas em direitos civis. Para nós, é essencial que todas as comunidades tenham experiências positivas e seguras em nossas plataformas, e continuaremos trabalhando para atingir esse objetivo."

"SE VOCÊ NÃO MEDIR, NÃO DÁ PARA AGIR"

Uma frente de trabalho que se desenhou em meio aos protestos pela morte de Floyd tratava dos danos desproporcionais que pessoas negras sofriam na moderação de conteúdo e perfis nas plataformas.

"Estamos dando a diferentes comunidades de usuários as opções de denúncia que eles precisam? Estariam diferentes comunidades de usuários sendo alvos desproporcionais de denúncias? Tendo conteúdo derrubado? Tendo suas contas desativadas? Tendo comentários marcados?", foram as perguntas feitas pela pessoa que criou o post na rede interna da empresa, datado de 3 de junho de 2020.

A ideia era olhar para impactos em cinco diferentes níveis da aplicação das diretrizes de comunidade:

- políticas;

- denúncias;

- remoção de conteúdo;

- detecção de classificação [classifier detection];

- e desabilitação de contas.

Mas a falta de dados era um impeditivo importante para esse trabalho.

"É difícil entender qualquer ponto disso sem a habilidade de olhar para dados ou um proxy de raça. Poderia haver auto identificação pelo usuário apenas para esse propósito interno e privado de tornar nosso produto mais justo, ou poderíamos estudar uma amostra de usuários com certos resultados de aplicação de políticas", escreveu a pessoa -- cujo nome foi ocultado pela equipe que administra o Facebook Papers.

Em 5 de junho, esse mesmo problema apareceu na discussão de outros funcionários num post em um grupo chamado Ideias de Integridade Para Combater Injustiça Racial.

"Enquanto nós não temos presumidamente nenhuma política pensada para colocar minorias em desvantagem, nós definitivamente temos políticas, práticas e comportamentos emergentes que fazem isso." – Funcionário não identificado do Facebook

"Nós deveríamos estudar compreensivamente como nossas decisões e como as mecânicas da rede social apoiam ou não comunidades minoritárias", escreveu o autor do post, que admitiu que seria difícil fazer progresso sem medições.

Para o autor, apesar da boa intenção do Facebook em não coletar dados sobre a raça dos usuários, a decisão era problemática por dois motivos:

- os sistemas de aprendizagem de máquina "quase certamente são capazes de implicitamente adivinhar a raça de muitos usuários".

- muitas das ideias discutidas no post são "extremamente difíceis de serem estudadas sem a possibilidade de conduzir análises com base em raça".

SOLUÇÃO TEMPORÁRIA QUE FICOU

Em setembro, alguns meses depois das primeiras discussões sobre justiça racial terem começado, um longo documento intitulado Permitindo Medição de Justiça Social com CEPs dos EUA foi publicado.

Com a figura de um carteiro simpático trazendo Boas Notícias" no cabeçalho, o autor do documento conclui que “para apoiar projetos de Justiça Racial, nós precisamos saber como as métricas variam em raça e etnicidade. Mas nosso compromisso à privacidade significa que temos que ser extremamente cautelosos ao coletar ou inferir raça e etnia”.

Não fica claro qual time ou área escreveu o documento, mas o texto enuncia que, para permitir desenvolvimentos de produto no curto prazo, diferentes times deverão usar dados de localização e do Censo para medir seus produtos por bairros, raça e etnicidade.

A ideia seria a de cruzar dados para estimar a incidência de população em cada localidade – assim como faz o Censo do IBGE, que foi lembrado nos comentários da postagem – para resolver o problema temporariamente. Pelo menos até que os times de Responsible AI e AI Policy desenvolvessem uma solução pensada junto a atores da sociedade civil que levasse em conta a privacidade do usuário.

Assim, as preocupações de privacidade, que antes teriam impedido a empresa de coletar tais dados, estariam resolvidas, visto que esse método não permitiria medir pessoas, mas sim localidades e geografias.

O que deveria ser temporário acabou se consolidando como solução, apresentada publicamente pela Meta, em meados de novembro.

Em um relatório assinado por pesquisadores do time de Inteligência Artificial, a empresa apresentou três abordagens para começar a medir dados precisos de raça de seus usuários: duas relacionadas ao processo que já estava em andamento e uma terceira baseada na autodeclaração dos usuários, sem permitir que a Meta veja dados individuais.

Para além dos obstáculos encontrados por pesquisadores dentro da Meta, a medição de dados sobre raça foi uma das recomendações do Civil Audit Report, relatório produzido ao longo de dois anos por uma auditoria independente contratada pela empresa após reiteradas críticas de que seus produtos eram discriminatórios.

Mesmo assim, a inferência de dados sobre raça, como a que a Meta pretende fazer agora, exige uma abordagem mais humanizada, ressalta Paulo Rená, ativista no Aqualtune Lab, professor universitário e doutorando em Direito.

"O Facebook pode inferir a raça das pessoas, não é um absurdo fazer uma inferência matemática sobre uma pessoa que more em determinado bairro, tenha determinada renda e determinado sobrenome", disse Rená para o Núcleo.

"Mas temos que ter cuidado com essas inferências, porque se eu tenho uma média que diz que se 90% de pessoas num grupo são de um jeito, isso não determina que aquela pessoa que eu estou analisando vai estar naquele 90% e não no 10%", explicou.

Segundo o pesquisador, não há nenhuma salvaguarda ou garantia de que o Facebook irá adotar essa abordagem.

BREITBART

Não foi só a ausência de dados que foi sinalizada como problema por funcionários. Enquanto os atos convocados pelo #BlackLivesMatter ainda aconteciam, veículos de imprensa dos Estados Unidos de extrema-direita associados ao ex-presidente Donald Trump passaram a chamar os atos de motins e vandalismo.

Um desses veículos foi o Breitbart, site que cresceu sob a liderança do ex-chefe de campanha de Trump, Steve Bannon, e figurava na aba de notícias do Facebook.

No dia 4 de junho de 2020, um funcionário do Facebook fez um post no Workplace (tipo um Facebook para empresas, utilizado pela própria companhia) com o título "Remova o Breitbart da aba de notícias", com uma imagem das manchetes mais recentes do site ultraconservador. "Preciso explicar essa?”, escreveu na legenda. Não era a primeira vez que o Breitbart era motivo de controvérsia dentro da empresa.

Em outubro de 2018 houve uma discussão sobre permitir o Breitbart como parte do programa de anúncios da plataforma. Isto é, empresas e marcas que contratavam Facebook Ads poderiam ver seus anúncios no site do Breitbart, o que gera dinheiro para a publicação.

Na ocasião, a pessoa que postou a nota disse que permitir que o Breitbart se monetizasse pelo Facebook era uma tomada de posição política e, também, ruim para os negócios, já que anunciantes estavam bloqueando seus anúncios de serem exibidos nesse site.

Mas em junho de 2020, o Breitbart e suas notícias estavam trazendo retorno à empresa em forma de engajamento.

Uma análise do MediaMatters, site de pesquisa de imprensa nos Estados Unidos, mostrou que posts sobre os atos #BLM de páginas de direita estavam recebendo mais engajamento que posts de páginas "neutras" ou de esquerda, concentrando 40% de todas as interações, apesar de representarem apenas ¼ de todos os posts sobre os protestos.

"Esses artigos são emblemáticos de um esforço coordenado pelo Breitbart e fontes hiperpartidárias semelhantes (nenhuma das quais pertencem na aba de notícias) para pintar negros americanos e movimentos liderados por negros de uma maneira muito negativa", comentou uma pessoa no post de 4 de junho.

"Se nossas diretrizes permitem que esse tipo de fonte de notícia [site ultraconservador Breibart News] seja amplificada como algo de credibilidade, então nossas diretrizes não estão 'lutando contra injustiça racial', como é o objetivo do grupo" – Resposta não identificada em post na rede interna do Facebook.

Para o pesquisador indiano Ramesh Srinivasan, doutor em Harvard e fundador do Laboratório de Cultura Digital da UCLA, as iniciativas de justiça racial da Meta se beneficiariam de um olhar mais colaborativo para fora do que voltando-se para dentro.

"Em vez de mais uma abordagem de cima para baixo, que tenta usar correlação para identificar raça, o que o Facebook deveria estar fazendo é trabalhar com organizações comunitárias e locais ao redor do mundo. Por exemplo, organizações que atuam com direitos civis para pessoas negras", disse em entrevista.

Parte da solução, na visão de Srinivasan, passa por abrir mão do poder de moderação.

"O Facebook não precisa publicar seu código-fonte, mas ele precisa realmente ceder o poder de moderação de conteúdo para muitas organizações diferentes que têm a expertise para entender questões raciais, questões de gênero, questões trans queer e também questões geográficas", afirmou.

COMO FIZEMOS ISSO

Essas informações fazem parte de documentos revelados à Comissão de Valores Mobiliários dos EUA (SEC, na sigla em inglês) e fornecidas ao Congresso dos Estados Unidos de forma editada pela assessoria legal de Frances Haugen, no que ficou conhecido como Facebook Papers. As versões editadas recebidas pelo Congresso dos EUA foram revisadas por um consórcio de veículos de notícias.

O Núcleo Jornalismo teve acesso aos documentos e publica esta reportagem em parceria com a Folha de São Paulo.

Esses documentos foram primeiramente noticiados pelo Wall Street Journal, que chamou a série de Facebook Files.

Reportagem Laís Martins

Pesquisa Samira Menezes

Colaboração Paula Soprana (Folha de São Paulo)

Arte Rodolfo Almeida

Edição Sérgio Spagnuolo

Texto atualizado às 18h29 de 2.dez.2021 para acrescentar informações no título de que trata de uma reportagem baseada em documentos do Facebook Papers.